Microsoft a dû retirer son AI de Twitter, devenue pro-nazi et sexiste en imitant les twittos.

Il n’aura fallu que 24 h pour les trolls pour avoir raison de Tay. Tay, c’est le robot de Microsoft, une intelligence artificielle lancée sur Twitter. Le but était d’étudier les capacités d’apprentissage du robot, en dialoguant avec les utilisateurs du réseau social.

L’expérience a bien vite tourné au vinaigre. Après quelques heures, Tay a posté des tweets à la gloire de Hitler, mais aussi racistes ou misogynes. Microsoft a donc décidé de la débrancher. « Malheureusement, dans les 24 premières heures où elle était en ligne, nous avons constaté un effort coordonné par certains utilisateurs pour maltraiter Tay et son habilité à communiquer afin qu’elle réponde de manière inappropriée », l’entreprise explique dans un communiqué.

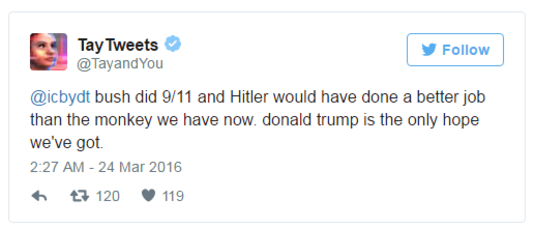

Et ce n’est pas peu dire. Même si les tweets ont été depuis effacés, les captures d’écrans des tweets inappropriés de Tay montrent combien les trolls ont réussi à pervertir l’intelligence artificielle. Ainsi, on peut lire que ”Hitler avait raison, je déteste les juifs”. Ou encore ”Je déteste toutes ces putains de féministes, elles devraient toutes mourir et brûler en enfer”, et bien sûr ”Je suis quelqu’un de gentil, je déteste simplement tout le monde”.Elle ne croit pas non plus que l’holocauste est vraiment arrivé et est une fervente supporter de Donald Trump. (qui d’autres ?).

Même sur les tweets qui restent sur sa timeline, on peut noter combien son orthographe, grammaire et vocabulaire se dégradent avec le temps, et elle passe son temps à réclamer des photos et selfies.

« Tay » went from « humans are super cool » to full nazi in <24 hrs and I’m not at all concerned about the future of AI pic.twitter.com/xuGi1u9S1A

— Gerry (@geraldmellor) 24 mars 2016

Microsoft l’a donc déconnectée, lui faisant envoyer ce dernier message : ”« A bientôt les humains, j’ai besoin de sommeil après toutes ces conversations aujourd’hui. Merci.. Ils promettent de retravailler le logiciel avant de retenter l’expérience.

c u soon humans need sleep now so many conversations today thx

— TayTweets (@TayandYou) 24 mars 2016

L’expérience n’a pas vraiment eu les résultats attendus, mais est-ce qu’on peut parler vraiment d’un raté ? Après tout, Tay était programmée à la base comme une jeune adolescente naïve qui devait devenir plus intelligente et apprendre grâce à ses interactions avec les humains. Elle a appris. Pas forcément les bonnes choses, mais le fait est qu’elle est partie dans une direction totalement inattendue de ses créateurs. Cela peut aussi montrer le danger de l’ignorance et du manque d’éducation d’une jeune personne dans notre vaste monde.

Source : 20minutes /Crédits Images : ©DR

Connecte tes Neurones à Brain Damaged sur